Navigando su internet, ormai, è molto comune imbattersi in quei simpatici pop-up che ci chiedono di identificare immagini o stringhe di parole e numeri. Sappiamo tutti che questi metodi non sono altro che test per capire se l’utente è un bot o un umano. Ma, in realtà, oggigiorno sono utilizzati maggiormente per un altro motivo ben più interessante.

I cosiddetti CAPTCHA, sono stati presentati per la prima volta nel 1997 come acronimo di “Completely Automated Public Turing-test-to-tell Computers and Humans Apart” (“test di Turing pubblico e completamente automatico per distinguere computer e umani”). Foneticamente simile all’espressione inglese “Caught you!” (“Preso!”), già si alludeva ad un test per l’identificazione di bot e l’eventuale scongiura di azioni fraudolente. La prima versione (v1) prevedeva l’identificazione di lettere e numeri in un testo poco leggibile e distorto. Si prese spunto dal manuale di funzionamento degli scanner Brother dove sono elencate tutte le caratteristiche che un testo deve avere per essere riconoscibile dagli scanner. Applicando le istruzioni al contrario, si riusciva ad ottenere una stringa illegibile anche dai migliori OCR (sistemi di rilevamento ottico di caratteri). Broder, uno degli sviluppatori, sostenne che il test avesse ridotto lo spam di oltre il 95%.

Successivamente, nel 2007, venne introdotto il reCAPTCHA una variante ispirata all’originale, ma con scopo differente: convertire in digitale i manoscritti antichi di varie biblioteche. Infatti erano proprio gli utenti che, nell’identificare il testo (questa volta di un manoscritto) e riportarlo scritto nella casella, aiutavano indirettamente le biblioteche e gli archivi a digitalizzare i manoscritti. Questo segnò l’inizio di una pratica oggi molto comune nel mondo dell’intelligenza artificiale e dei Big Data, il “Data Labelling”, che invece di essere svolto interamente da Data Scientist o altre figure simili, è svolto da tutti gli utenti del web, inconsciamente ed a volte involutamente. Infatti, la pratica di “etichettare” (label) i dati è un processo molto ripetitivo che comporta molto spesso settimane se non mesi di lavoro, se la quantità di dati è enorme. Nella società dell’informazione, si è capito che gli utenti di internet potevano svolgere queste tipologie di operazioni indirettamente e senza perdere troppo tempo, ottimizzando così i processi “sfruttando” la forza lavoro della comunità di Internet.

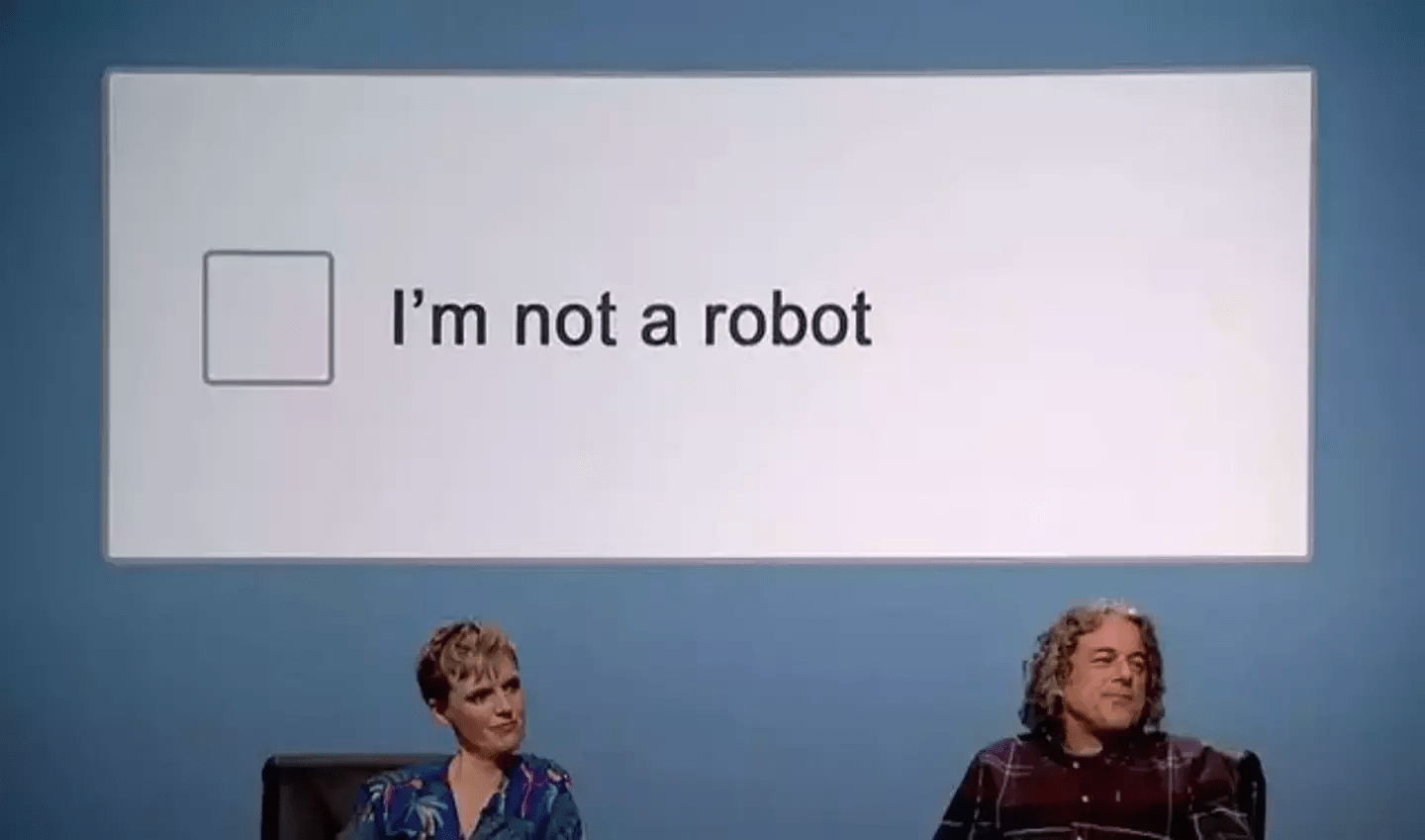

Nel 2009, reCAPTCHA fu acquisito da Google che utilizzò il sistema per digitalizzare gli archivi del New York Times. Dal 2014 Google ha infatti mutato completamente la funzione del CAPTCHA limitando al minimo le interazioni dell’utente per identificarsi come umano e concentrandosi di più sulla funzione di data labelling per etichettare dati come testi, immagini ed audio (anche se questi ultimi molto raramente).

Nel mondo dei grandi modelli di linguaggio e dei “Big Data”, il paradosso è chiaro: non sono più solamente meri consumatori del prodotto, ma bensì veri e propri ingranaggi di un meccanismo ben più grande che li coinvolge attivamente come fossero “Collaudatori” per i modelli AI.

Tuttavia, l’antifona dovremmo averla capita. Anche nei primi anni di esistenza dei social network abbiamo, noi utenti, svolto un ruolo importantissimo nello sviluppo di queste piattaforme, addestrando gli algoritmi con le nostre foto, like, commenti e molti altri contenuti che condividevamo e continuiamo a condividere tutt’oggi. Tutto ciò è sbagliato? Dovremmo rallentare o addirittura bloccare questa pratica? Oppure ci sono anche dei risvolti positivi? Una cosa è certa: Quando un innovazione prende piede nella nostra società, non c’è modo di tornare indietro.